Problemy z pamięcią RAM i rozwiązanie alternatywne

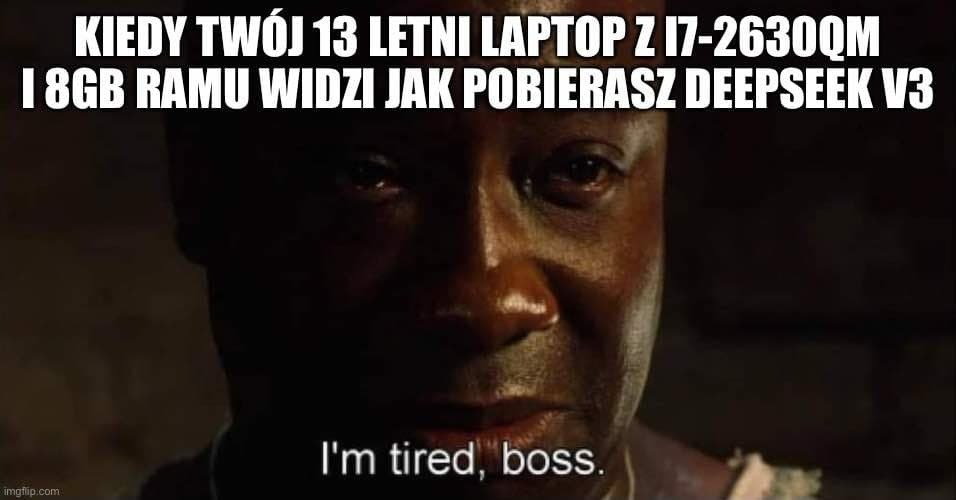

Gdy model został pobrany, pojawił się kolejny problem – DeepSeek wymagał ponad 462 GB pamięci RAM, co znacznie przewyższało moje skromne 8 GB. Aby obejść ten problem, postanowiłem wykorzystać kartę SD Samsung 512 GB jako rozszerzenie pamięci wirtualnej. Przeniesienie plików modelu na kartę SD zajęło kilka godzin, a następnie skonfigurowałem plik stronicowania na wolnym miejscu dyskowym. To rozwiązanie pozwoliło systemowi kontynuować działanie, choć kosztem wydajności.

Długi czas uruchamiania i finalne rezultaty

Po zakończeniu konfiguracji przyszedł czas na właściwe uruchomienie modelu. Proces ładowania trwał wiele godzin – model zaczął odpowiadać dopiero po około sześciu godzinach przetwarzania danych. Prędkość działania pozostawiała wiele do życzenia, ale mimo wszystko – działało!

Ostatecznie eksperyment zakończył się sukcesem, choć nie było to praktyczne rozwiązanie. Model działał bardzo wolno, dysk SSD intensywnie się eksploatował, a pamięć RAM osiągała swoje granice. Niemniej jednak samo uruchomienie tak wymagającego modelu na sprzęcie sprzed ponad dekady było niezwykle satysfakcjonujące.

Wnioski i podsumowanie

Mój eksperyment pokazał, że przy odpowiedniej konfiguracji można uruchomić nowoczesne modele AI nawet na starszym sprzęcie. Oczywiście, nie jest to rozwiązanie rekomendowane do pracy produkcyjnej, ale jako ćwiczenie z zakresu optymalizacji zasobów – jak najbardziej warte uwagi. Dla osób zainteresowanych testowaniem lokalnym, kluczowe jest odpowiednie zarządzanie pamięcią i przechowywaniem danych, a także świadomość ograniczeń sprzętowych.

Czy warto było poświęcić na to ponad dobę? Z perspektywy praktycznej – niekoniecznie. Ale jako eksperyment techniczny? Jak najbardziej!

Dla tych, którzy mają dostęp do serwera z odpowiednią ilością RAM-u, warto rozważyć instalację modelu na takim właśnie sprzęcie. Takie rozwiązanie daje pełną kontrolę nad zapytaniami, eliminuje zależność od zewnętrznych dostawców i pozwala uniknąć cenzury stosowanej w modelach chmurowych. Jeśli interesują Was podobne wyzwania w świecie AI i testowania technologii, zapraszamy do śledzenia naszego bloga oraz udziału w naszych szkoleniach.